Vídeos que viralizam nas redes sociais mostrando figuras públicas em situações quase inacreditáveis como, por exemplo, o presidente ucraniano Volodymyr Zelensky anunciando total rendição às tropas da Rússia. Será verdade? Afinal de contas parece tão real... A resposta é não, pois trata-se de uma "deep fake", "falsificação profunda" que, como a tradução indica, é tão bem feita que pode enganar até os mais atentos.

O que muita gente não sabe, porém, é que esse tipo de golpe, além de manipular vídeos com celebridades e políticos famosos, também prejudica empresas e cidadãos comuns, que podem ser envolvidas em fraudes de identidade e extorsões.

Segundo estudo da empresa de segurança Kaspersky, 65% dos brasileiros ignoram a sua existência e 71% não reconhecem quando um vídeo foi editado digitalmente usando essa técnica.

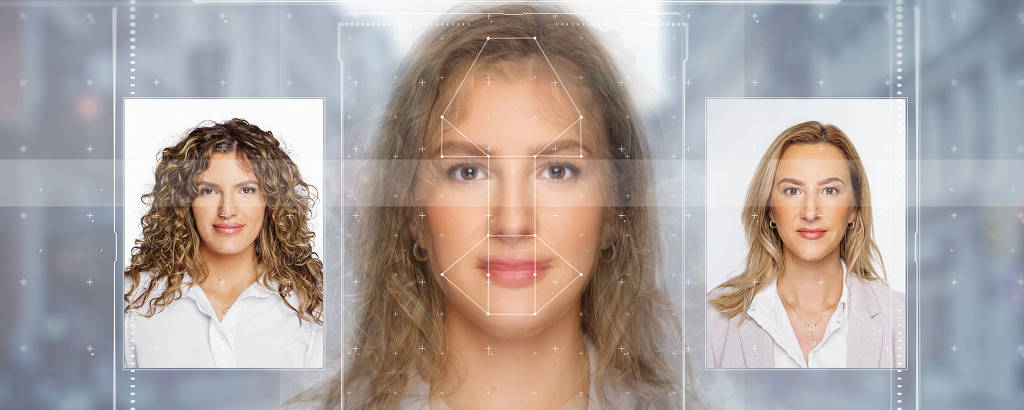

"Deep fake pode ser definido como a criação de vídeos e áudios falsos por meio de inteligência artificial", explica Guilherme Bacellar, especialista de segurança cibernética e fraude da Unico.

A prática costuma utilizar um vídeo de referência e a face (ou corpo) de outra pessoa, que não fazia parte do vídeo original. "É possível ainda criar áudios falsos fazendo a inteligência artificial aprender como uma pessoa fala e, a partir daí, obter uma montagem com outras falas, inclusive alterando os lábios para acompanhar as palavras que são ditas", explica.

Também há vídeos que alteram o rosto ou o corpo de uma pessoa e reconstroem o movimento dos lábios para manter o áudio original. "O objetivo dessas ações é prejudicar a imagem de figuras públicas ou obter ganhos financeiros enganando pessoas comuns", diz.

A prática vem evoluindo rapidamente, tornando cada vez mais difícil a sua identificação. Isso ocorre porque as novas redes neurais (sistemas de computação que funcionam como neurônios do cérebro humano), a evolução da capacidade de processamento, a redução de custos da computação em nuvem e as novas placas de vídeo (GPUs) com foco em inteligência artificial têm facilitado o acesso a essa tecnologia, contribuindo para aumentar a qualidade dos vídeos.

No entanto, os criminosos não precisam de tanto conhecimento e tecnologia para aplicar seus golpes. Isso porque deep fakes criados para serem distribuídos por apps de mensagens não exigem tanta qualidade. Aplicativos para celular de troca (face swap) ou animação de face para fins de diversão são comumente usados. "As telas pequenas escondem as imperfeições de vídeos que são gerados por aplicativos on-line ou smartphones", explica o especialista.

O perigo é que, para o cidadão comum, o deep fake pode ser o ponto de partida para uma fraude financeira, a compra de um veículo ou de um imóvel. "Para empresas, um deep fake de um CFO ou CEO enviado para algum funcionário pode ser a origem de um desvio financeiro ou sabotagem de um grande negócio", explica.

A recomendação para pessoas físicas se protegerem é diminuir a exposição de fotos com rostos e vídeos pessoais na internet. "Deve-se manter as redes sociais configuradas como privadas, já que fotos, áudios ou vídeos disponíveis publicamente podem ser utilizadas para alimentar a inteligência artificial e criar deep fake."

Para empresas, a melhor forma de proteção é utilizar uma tecnologia eficiente para identificação desse tipo de fraude. "Já existem soluções de IA com taxas de acerto superiores a 70%", diz Bacellar. Isso é possível porque o computador pode "enxergar" mínimos movimentos de rosto e lábios e "ouvir" os menores pedaços que formam as palavras e sílabas da fala apresentada.

"Isso, aliado ao fato de que essas inteligências artificiais são treinadas com milhares de vídeos reais e centenas de deep fakes, torna a detecção cada dia mais eficiente e precisa", explica.

"A maioria das empresas que investe na detecção da prática utiliza soluções de biometria facial, assunto em que a Unico é especialista", afirma Bacellar. "Nós aplicamos diversas camadas de proteção e detecção que servem não apenas para combater deep fake, mas detectam também outros tipos de ataque até mais sofisticados nos quais o criminoso tenta se fazer passar por outra pessoa."

Além disso, a biometria facial parte do princípio da presença ao vivo. Isso significa que para ter uma biometria facial válida é necessário que a pessoa esteja de fato em frente a câmera que realiza a captura. "Um vídeo de deep fake não é uma presença física diante da câmera e, portanto, não engana nossas camadas de proteção."